Dengan kemajuan teknologi yang begitu pesat di sekitar kita, terkadang kesalahpahaman dapat memengaruhi pemahaman kita bersama. Pada artikel ini, Computory akan membahas beberapa hal paling umum yang dibicarakan orang tentang hardware / perangkat keras komputer, namun pada kenyataannya tidak demikian alias hanya sekedar mitos atau hoaks.

Membandingkan CPU dari jumlah core dan kecepatan clock

Jika Anda sudah lama mempelajari komputer, pada titik tertentu Anda mungkin pernah mendengar seseorang membuat perbandingan berikut: “CPU A memiliki 4 core dan berjalan pada 4 GHz. CPU B memiliki 6 core dan berjalan pada 3 GHz. Karena 4 x 4 = 16 kurang dari 6 x 3 = 18, maka CPU B sudah pasti lebih baik “.

Ini adalah salah satu kesalahan umum saat bicara tentang CPU komputer. Ada begitu banyak variasi dan parameter sehingga tidak mungkin untuk membandingkan CPU dengan cara ini.

Meskipun di atas kertas kedua prosesor tampak jelas siapa pemenangnya (CPU B), namun, begitu Anda mulai menambahkan kompleksitas chip di lapangan, perbandingan itu menjadi tidak berarti.

Ada pekerjaan yang lebih menyukai frekuensi clock speed yang lebih tinggi, dan ada pula pekerjaan lainnya yang mendapatkan keuntungan dari jumlah core yang dimiliki prosesor.

Satu CPU dapat mengkonsumsi lebih banyak daya sehingga peningkatan kinerja menjadi sia-sia. Satu CPU mungkin memiliki lebih banyak cache daripada yang lain, atau pipeline yang lebih dioptimalkan. Jadi, jangan pernah membandingkan CPU dengan cara ini.

Clock speed adalah indikator kinerja yang paling penting

Biasanya merupakan lanjutan dari mitos pertama di atas, penting untuk dipahami bahwa clock speed bukanlah segalanya. Dua CPU dalam kategori harga yang sama yang berjalan pada frekuensi yang sama dapat memiliki kinerja yang sangat bervariasi satu sama lain.

Tentu saja kecepatan core dan clock memiliki dampak, tetapi begitu Anda mencapai titik tertentu, ada faktor lain yang berperan lebih besar. CPU dapat menghabiskan banyak waktu menunggu bagian lain dari sistem, jadi ukuran cache dan arsitektur sangat penting. Ini dapat mengurangi waktu yang terbuang dan meningkatkan kinerja prosesor.

Arsitektur sistem yang luas juga dapat memainkan peran besar. Sangat mungkin bahwa CPU yang lambat dapat memproses lebih banyak data daripada yang cepat jika arsitektur internalnya dioptimalkan dengan lebih baik. Lebih tepatnya, kinerja per watt menjadi faktor dominan yang digunakan untuk mengukur kinerja, terutama dalam desain prosesor yang lebih baru.

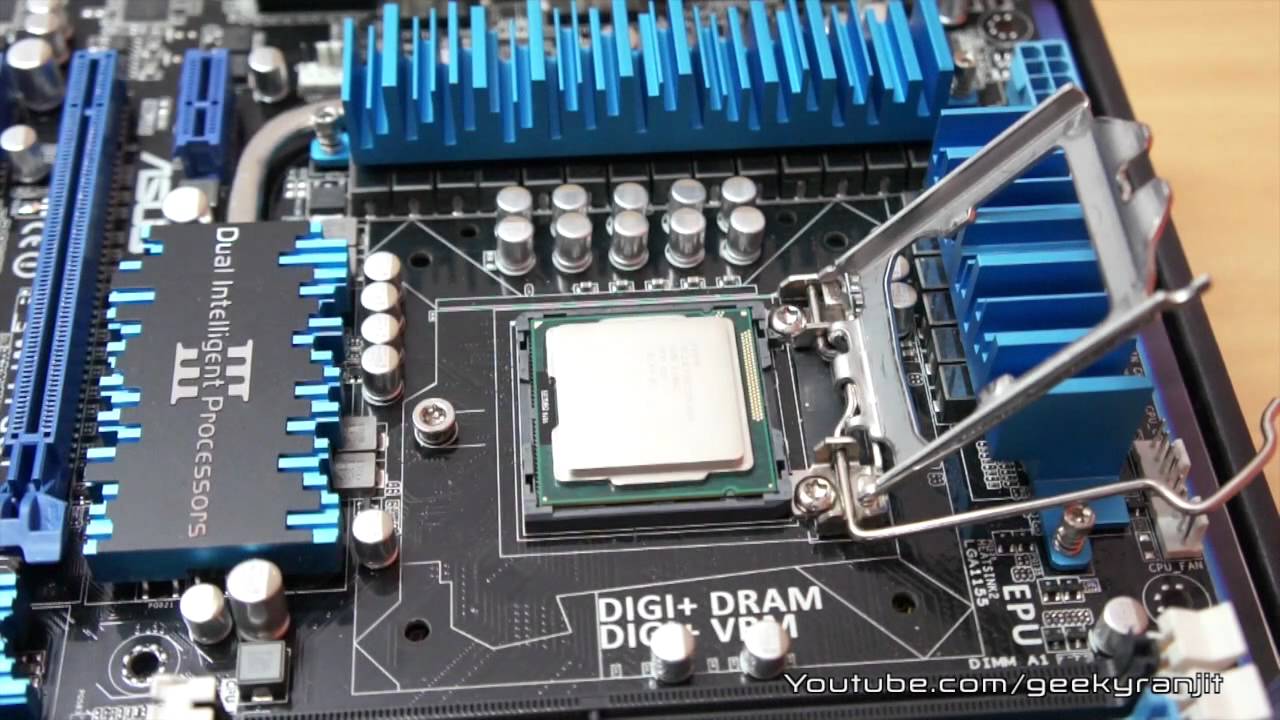

Otak dari suatu perangkat adalah CPU/Prosesor

Ini adalah sesuatu yang dulunya benar, tetapi menjadi semakin tidak benar setiap hari. Kita cenderung mengelompokkan sekumpulan fungsionalitas ke dalam frase “CPU” atau “prosesor” padahal kenyataannya, itu hanya satu bagian dari gambaran yang lebih besar. Tren saat ini, yang dikenal sebagai komputasi heterogen, melibatkan penggabungan banyak elemen komputasi menjadi satu chip.

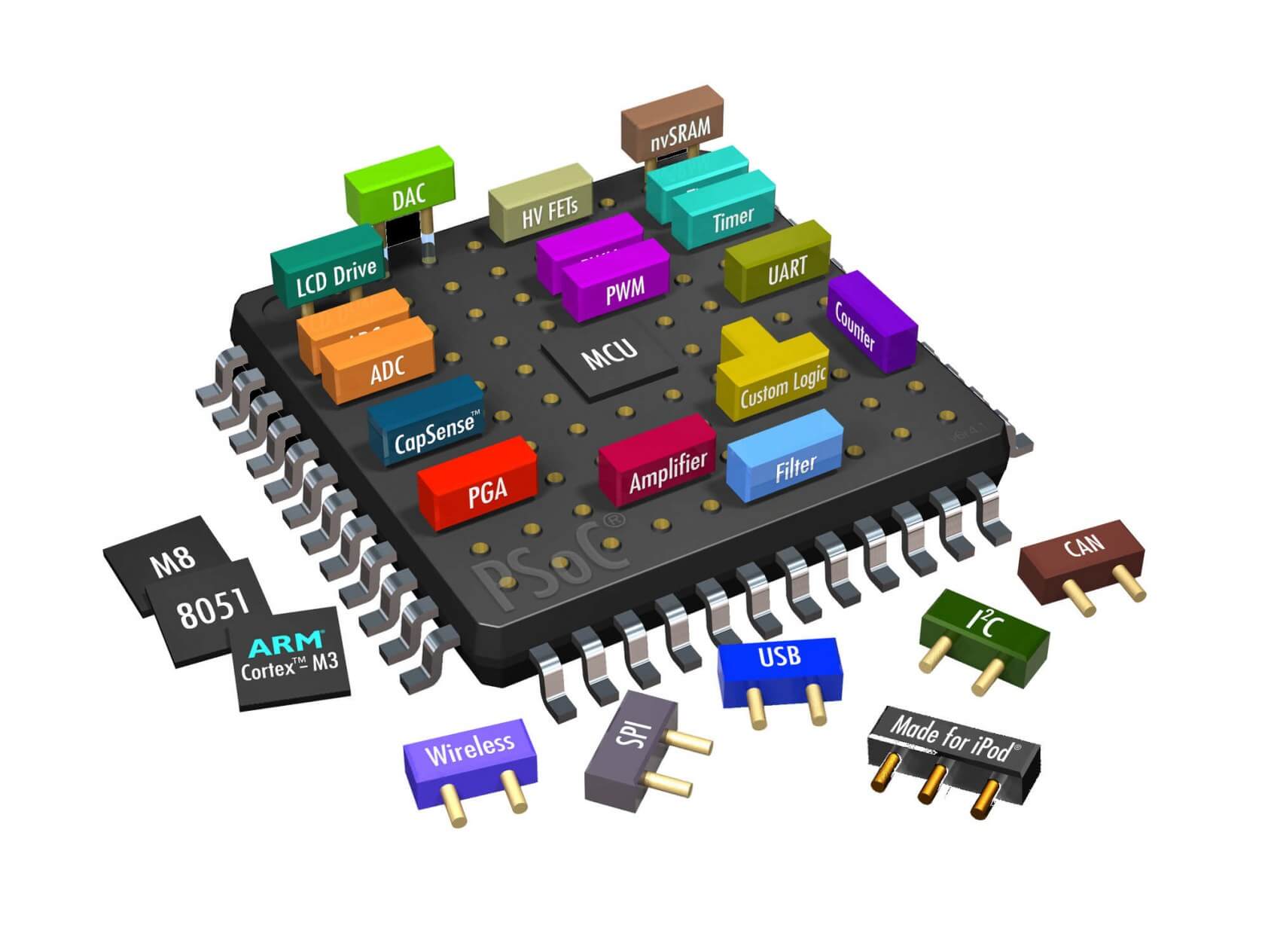

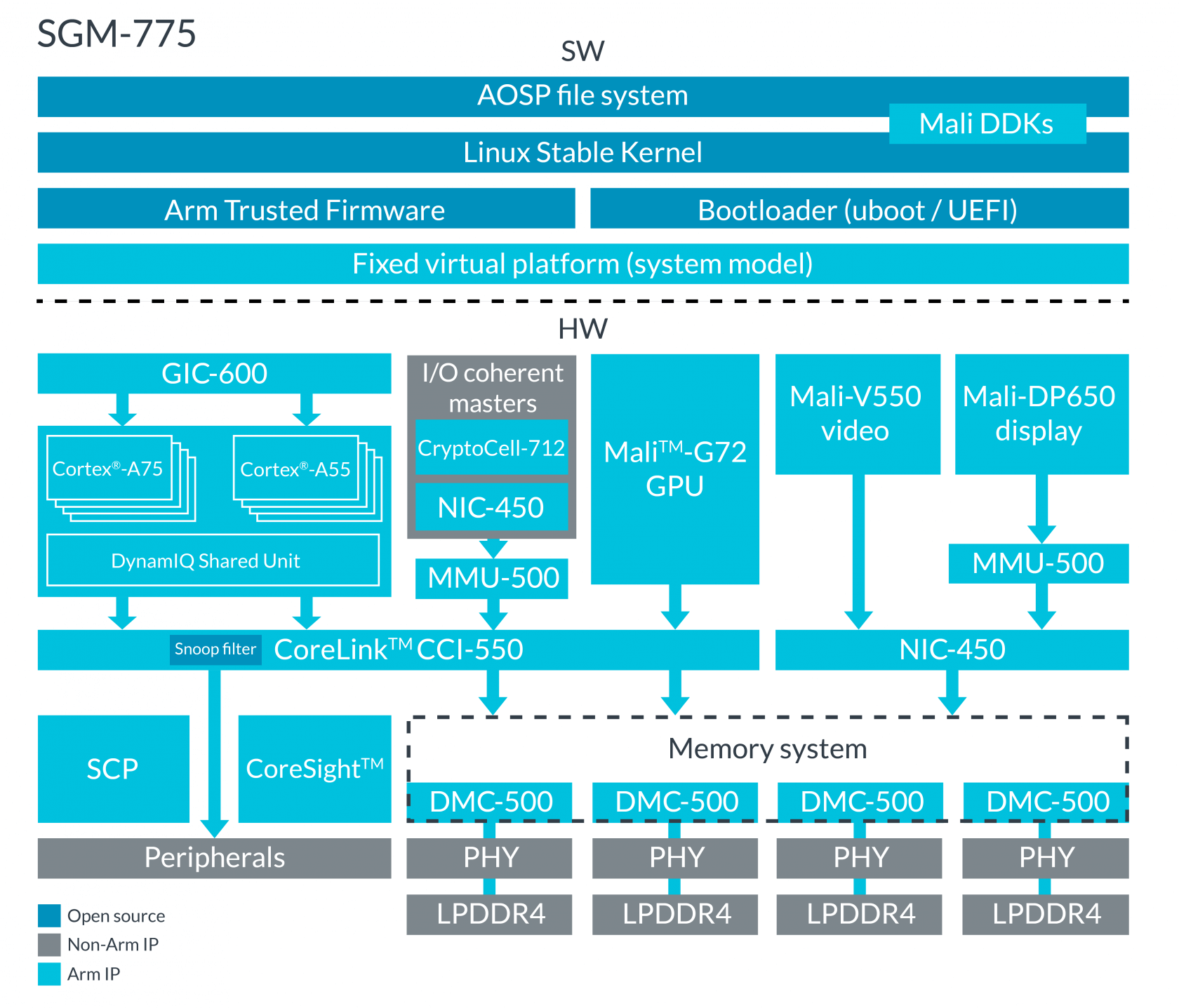

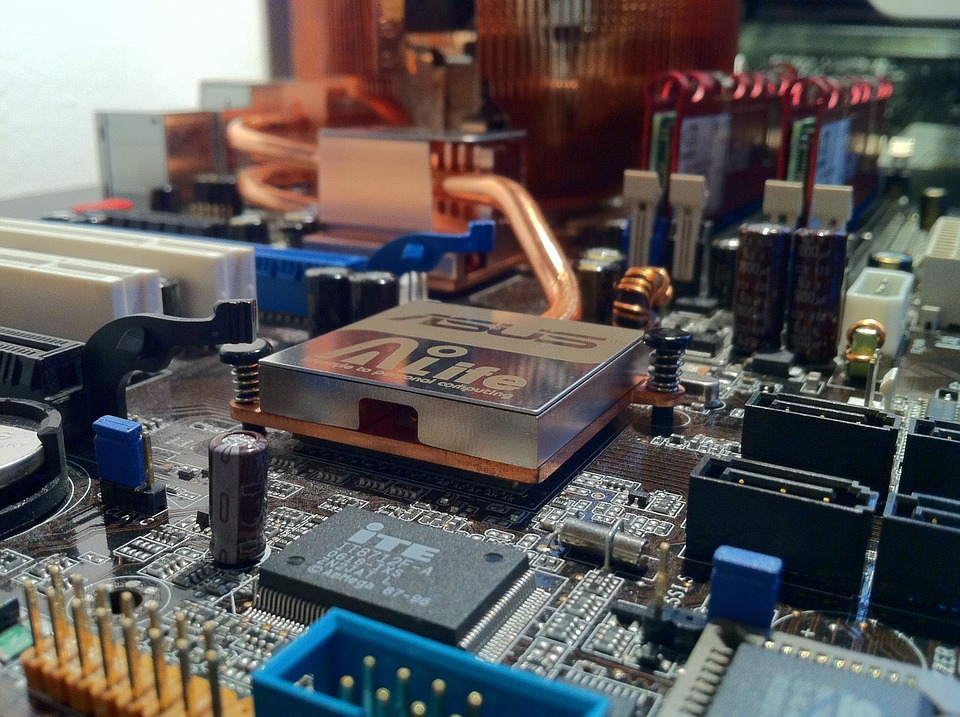

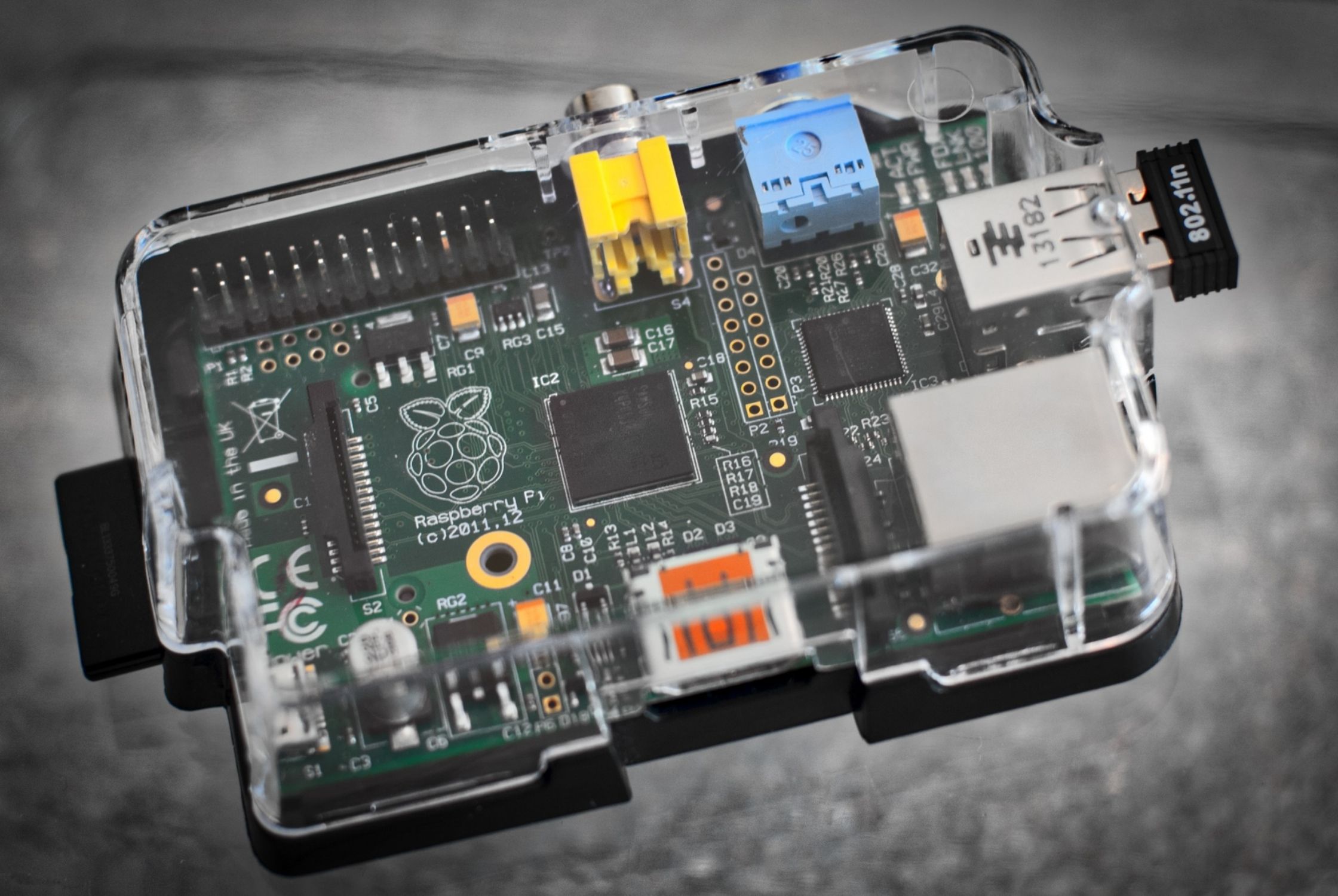

Secara umum, chip di sebagian besar desktop dan laptop adalah CPU. Untuk hampir semua perangkat elektronik lainnya, kebanyakan yang digunakan adalah sistem pada chip / System on a Chip (SoC).

Motherboard PC desktop mampu menyediakan ruang untuk menyebarkan lusinan chip terpisah, masing-masing melayani fungsi tertentu, tetapi itu tidak mungkin dilakukan di sebagian besar platform lain. Perusahaan semakin mencoba untuk mengemas fungsionalitas sebanyak mungkin ke dalam satu chip untuk mencapai kinerja yang lebih baik dan efisiensi daya.

Selain CPU, SoC di ponsel Anda kemungkinan juga memiliki GPU, RAM, encoder / decoder media, jaringan, manajemen daya, dan lusinan bagian lainnya. Meskipun Anda dapat menganggapnya sebagai prosesor dalam pengertian umum, CPU sebenarnya hanyalah salah satu dari banyak komponen yang membentuk SoC modern.

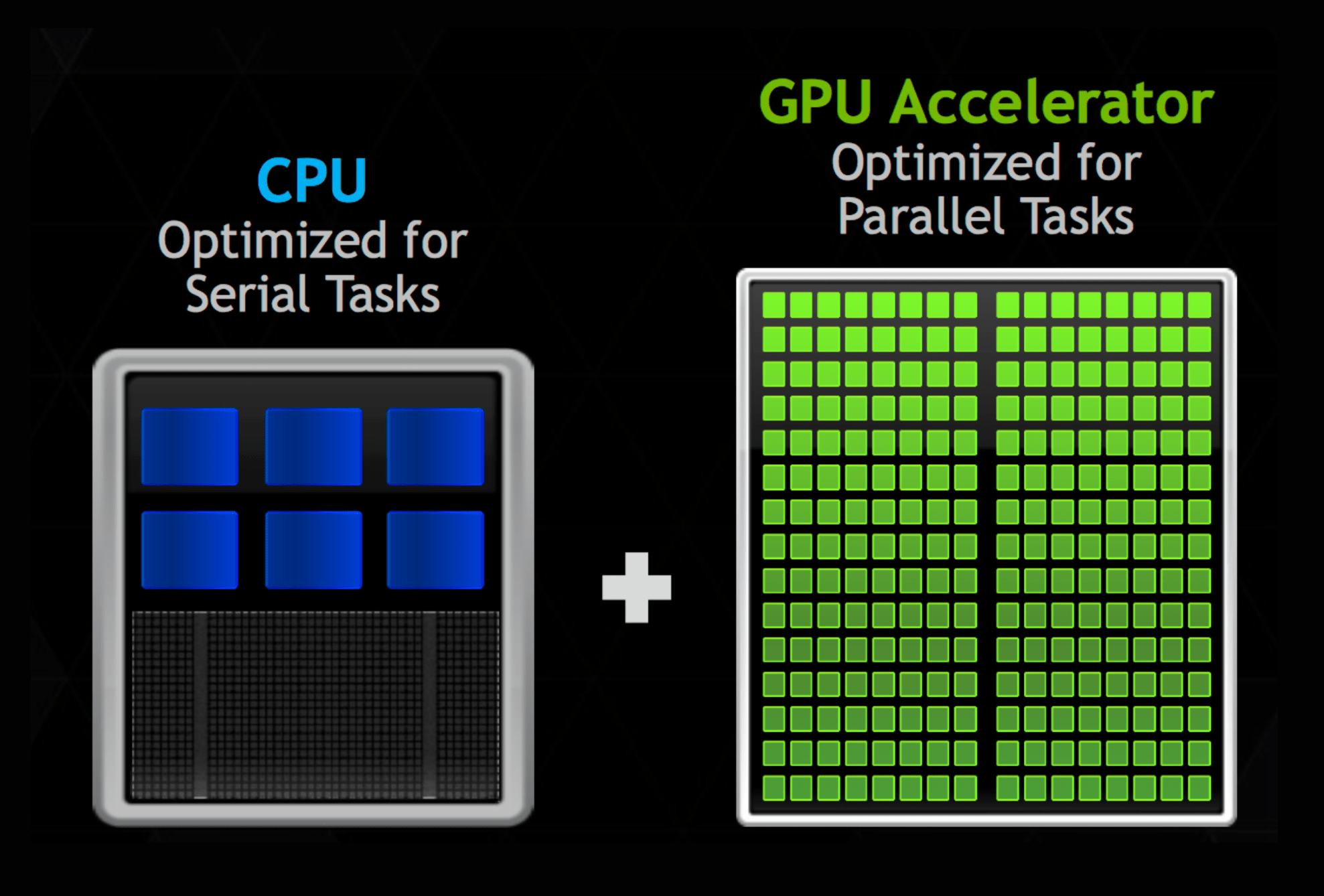

Membandingkan jumlah core GPU adalah cara yang berguna untuk mengukur kinerja

Saat membandingkan CPU dengan GPU, perbedaan terbesar adalah jumlah core yang mereka miliki. CPU memiliki beberapa core/inti yang sangat kuat, sedangkan GPU memiliki ratusan atau ribuan inti yang kurang bertenaga. Ini memungkinkan mereka memproses lebih banyak pekerjaan secara paralel.

Sama seperti bagaimana CPU quad core dari satu perusahaan dapat memiliki kinerja yang sangat berbeda dari CPU quad core dari perusahaan lain, hal yang sama juga berlaku untuk GPU. Tidak ada cara yang baik untuk membandingkan jumlah inti GPU di berbagai vendor. Setiap pabrikan akan memiliki arsitektur yang sangat berbeda yang membuat jenis metrik ini hampir tidak berarti.

Misalnya, satu perusahaan mungkin memilih lebih sedikit core tetapi menambahkan lebih banyak fungsionalitas, sementara yang lain mungkin lebih memilih core yang banyak tetapi masing-masing memiliki fungsionalitas yang lebih rendah. Namun, seperti halnya dengan CPU, perbandingan antara GPU dari vendor yang sama dan dalam keluarga produk yang sama benar-benar valid.

Membandingkan FLOP adalah cara yang berguna untuk mengukur kinerja

Ketika sebuah chip atau superkomputer berkinerja tinggi baru diluncurkan, salah satu hal pertama yang diiklankan adalah berapa banyak FLOP yang dapat dihasilkannya. FLOP adalah singkatan dari Floating Point Operations per Second dan mengukur berapa banyak instruksi yang dapat dilakukan oleh suatu sistem.

Ini tampak cukup jelas, tetapi tentu saja, vendor dapat bermain-main dengan angka untuk membuat produk mereka tampak lebih cepat daripada yang sebenarnya. Misalnya, menghitung 1.0 + 1.0 jauh lebih mudah daripada menghitung 1234.5678 + 8765.4321. Perusahaan dapat mengacaukan jenis kalkulasi dan ketepatannya yang terkait untuk meningkatkan jumlahnya.

Melihat FLOP juga hanya mengukur kinerja komputasi CPU / GPU mentah dan mengabaikan beberapa faktor penting lainnya seperti bandwidth memori. Perusahaan juga dapat mengoptimalkan tolok ukur yang mereka jalankan untuk menguntungkan bagian mereka sendiri secara tidak adil.

ARM adalah perusahaan pembuat chip

Hampir semua sistem bertenaga rendah dan tertanam didukung oleh beberapa bentuk prosesor ARM. Yang penting untuk diperhatikan adalah ARM sebenarnya tidak membuat chip fisik. Sebaliknya, mereka merancang cetak biru tentang bagaimana chip ini harus beroperasi, dan membiarkan perusahaan lain membangunnya.

Misalnya, SoC A13 di iPhone terbaru menggunakan arsitektur ARM, tetapi dirancang oleh Apple. Ini seperti memberikan kamus kepada penulis dan meminta mereka menulis sesuatu. Penulis memiliki blok bangunan dan harus mematuhi pedoman tentang bagaimana kata-kata dapat digunakan, tetapi mereka bebas menulis apa pun yang mereka inginkan.

Dengan melisensikan kekayaan intelektual (IP) mereka, ARM memungkinkan Apple, Qualcomm, Samsung, dan banyak lainnya untuk membuat chip mereka sendiri yang paling sesuai dengan kebutuhan mereka sendiri. Hal ini memungkinkan chip yang dirancang untuk TV fokus pada encoding dan decoding media, sementara chip yang dirancang untuk digunakan pada mouse nirkabel akan fokus pada konsumsi daya yang rendah.

Chip ARM di mouse tidak membutuhkan GPU atau CPU yang sangat bertenaga. Karena semua prosesor yang berbasis ARM menggunakan rangkaian desain dan cetak biru inti yang sama, semuanya dapat menjalankan aplikasi yang sama. Ini membuat pekerjaan pengembang lebih mudah dan meningkatkan kompatibilitas.

ARM vs. x86

ARM dan x86 adalah dua arsitektur set instruksi dominan yang menentukan bagaimana perangkat keras komputer bekerja dan berinteraksi. ARM adalah raja dari sistem seluler dan tertanam, sedangkan x86 mengontrol pasar laptop, desktop, dan server. Ada beberapa arsitektur lain, tetapi mereka melayani lebih banyak aplikasi khusus.

Ketika berbicara tentang arsitektur set instruksi, itu mengacu pada cara prosesor dirancang di dalam. Ini seperti menerjemahkan buku ke bahasa lain. Anda dapat menyampaikan ide yang sama, tetapi Anda hanya menulisnya dengan cara yang berbeda. Sangat mungkin untuk menulis program dan mengkompilasinya dengan satu cara untuk dijalankan pada prosesor x86 dan cara lain untuk dijalankan di ARM.

ARM telah membedakan dari x86 dalam beberapa hal utama, yang memungkinkan mereka mendominasi pasar seluler. Yang paling penting adalah fleksibilitas dan berbagai penawaran teknologi. Saat membangun CPU ARM, hampir seperti insinyur bermain dengan Lego. Mereka dapat memilih dan memilih komponen apa pun yang mereka inginkan untuk membangun CPU yang sempurna untuk aplikasi mereka. Butuh chip untuk memproses banyak video? Anda dapat menambahkan GPU yang lebih bertenaga. Perlu menjalankan banyak keamanan dan enkripsi? Anda dapat menambahkan akselerator khusus. Fokus ARM untuk melisensikan teknologi mereka daripada menjual chip fisik adalah salah satu alasan utama mengapa arsitektur mereka paling banyak diproduksi. Intel dan AMD di sisi lain telah mengalami stagnasi di area ini yang menciptakan ruang hampa yang dikendalikan ARM.

Intel paling sering dikaitkan dengan x86 dan saat mereka membuatnya, prosesor AMD menjalankan arsitektur yang sama. Jika Anda melihat x86-64 disebutkan di suatu tempat, itu hanya x86 versi 64-bit. Jika Anda menjalankan Windows, Anda mungkin bertanya-tanya mengapa ada “Program Files” dan “Program Files (x86)”. Bukan program di folder pertama tidak menggunakan x86, hanya saja program tersebut 64-bit sedangkan program di “Program Files (x86)” adalah 32-bit.

Satu area lain yang dapat menyebabkan kebingungan antara ARM dan x86 adalah dalam performa relatifnya. Sangat mudah untuk berpikir bahwa prosesor x86 selalu lebih cepat daripada prosesor ARM dan itulah mengapa kami tidak melihat prosesor ARM di sistem kelas atas. Meskipun itu biasanya benar (sampai sekarang), itu bukanlah perbandingan yang benar-benar adil dan itu meleset. Seluruh filosofi desain ARM adalah fokus pada efisiensi dan konsumsi daya rendah. Mereka membiarkan x86 memiliki pasar kelas atas karena mereka tahu bahwa mereka tidak dapat bersaing di sana. Sementara Intel dan AMD fokus pada kinerja maksimum dengan x86, ARM memaksimalkan kinerja per Watt.

GPU lebih cepat daripada CPU

Selama beberapa tahun terakhir, kita telah melihat peningkatan besar dalam kinerja dan prevalensi GPU. Banyak beban kerja yang secara tradisional dijalankan pada CPU telah dipindahkan ke GPU untuk memanfaatkan paralelismenya. Untuk tugas yang memiliki banyak bagian kecil yang dapat dihitung pada saat bersamaan, GPU jauh lebih cepat daripada CPU. Itu tidak selalu terjadi, dan itulah alasan kita masih membutuhkan CPU.

Untuk memanfaatkan CPU atau GPU dengan tepat, pengembang harus merancang kode mereka dengan kompiler dan antarmuka khusus yang dioptimalkan untuk platform. Inti pemrosesan internal pada GPU, yang jumlahnya bisa ribuan, sangat mendasar dibandingkan dengan CPU. Mereka dirancang untuk operasi kecil yang berulang-ulang.

Sebaliknya, inti dalam CPU dirancang untuk berbagai operasi kompleks yang sangat luas. Untuk program yang tidak dapat diparalelkan, CPU akan selalu lebih cepat. Dengan kompiler yang tepat, secara teknis mungkin untuk menjalankan kode CPU pada GPU dan sebaliknya, tetapi manfaat nyata hanya datang jika program dioptimalkan untuk platform tertentu. Jika Anda hanya melihat harga, CPU termahal masing-masing dapat berharga $ 50.000 sementara GPU top-of-the-line kurang dari setengahnya. Singkatnya, CPU dan GPU sama-sama unggul di bidangnya masing-masing dan tidak ada yang lebih cepat dari yang lain.

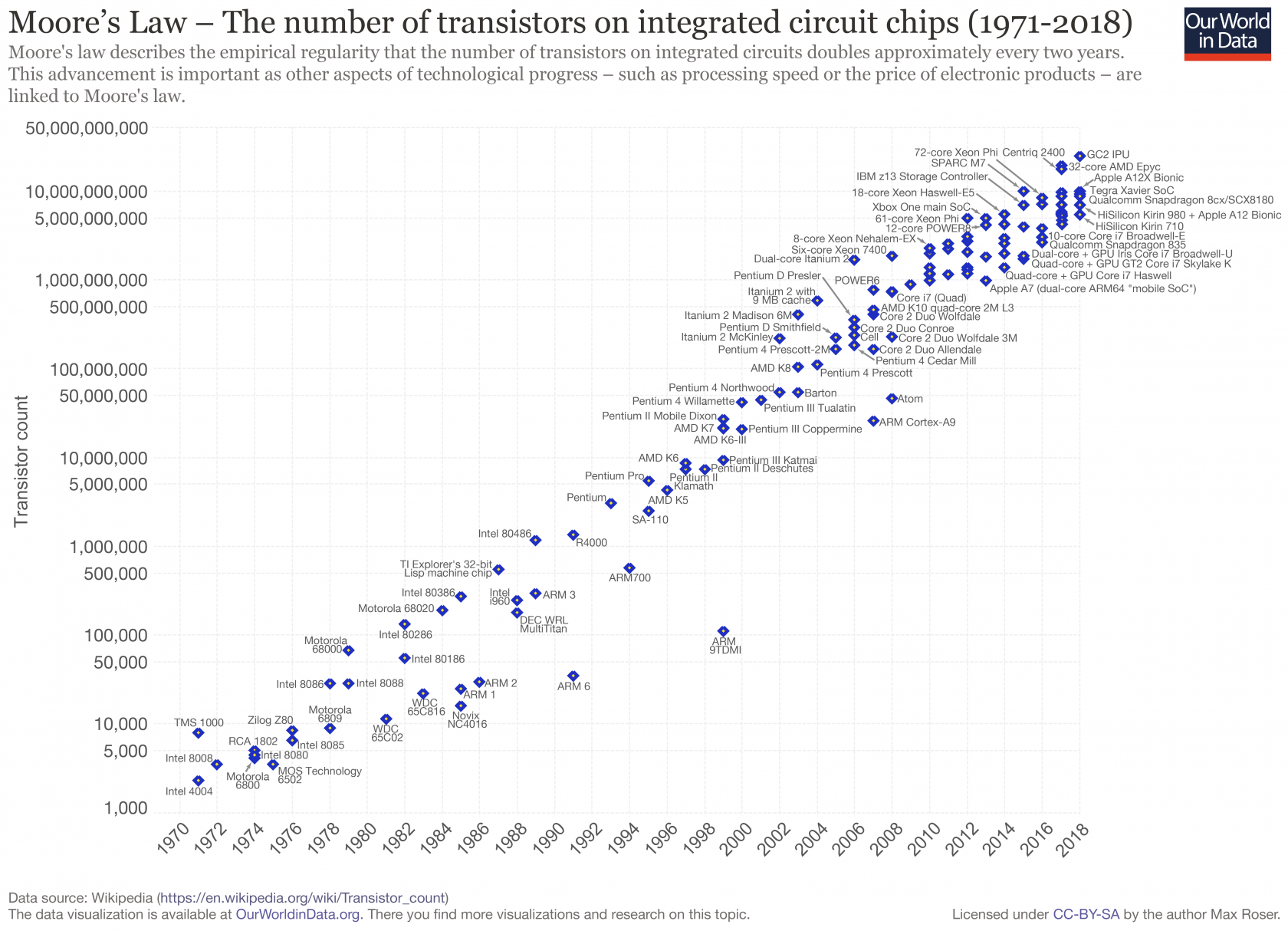

Prosesor akan selalu semakin cepat

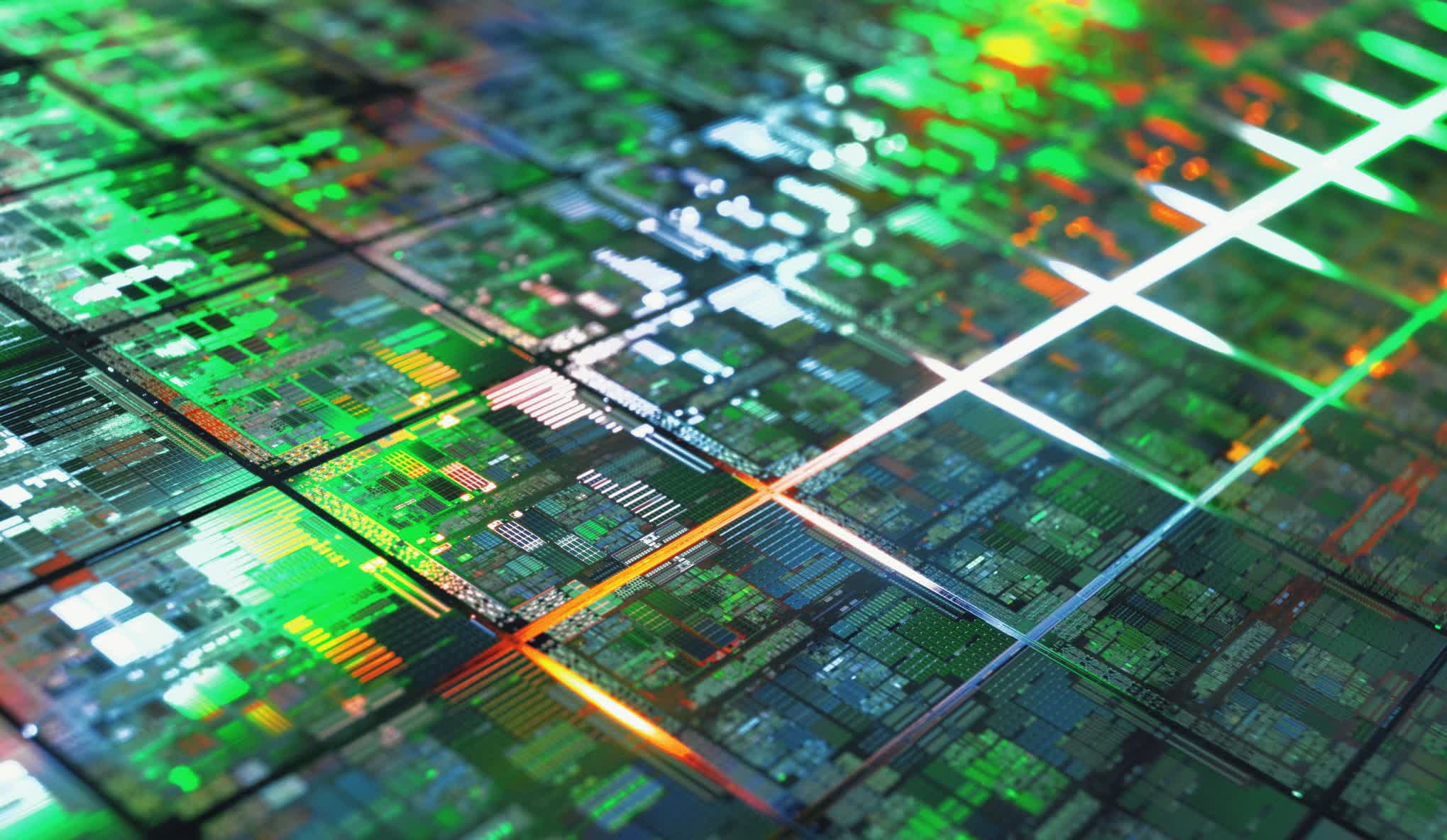

Salah satu representasi paling terkenal dari industri teknologi adalah Hukum Moore. Ini adalah pengamatan bahwa jumlah transistor dalam sebuah chip sekitar dua kali lipat setiap 2 tahun. Ini telah akurat selama 40 tahun terakhir, tetapi kami berada di ujungnya dan penskalaan tidak terjadi seperti dulu.

Jika kita tidak dapat menambahkan lebih banyak transistor ke chip, satu pemikiran adalah kita bisa membuatnya lebih besar. Batasan di sini adalah mendapatkan daya yang cukup untuk chip dan kemudian menghilangkan panas yang dihasilkannya. Chip modern menarik arus ratusan Amp dan menghasilkan panas ratusan Watt.

Sistem pendinginan dan pengiriman daya saat ini sedang berjuang untuk mengimbangi dan mendekati batas dari apa yang dapat diberi daya dan didinginkan. Itulah mengapa kita tidak bisa begitu saja membuat chip yang lebih besar.

Jika kita tidak dapat membuat chip yang lebih besar, tidak bisakah kita membuat transistor pada chip lebih kecil untuk menambah kinerja? Konsep itu telah berlaku selama beberapa dekade terakhir, tetapi kami mendekati batas mendasar bagaimana transistor kecil bisa didapat.

Dengan proses 7nm baru dan proses 3nm di masa mendatang, efek kuantum mulai menjadi masalah besar dan transistor berhenti berperilaku dengan benar. Masih ada sedikit ruang lagi untuk menyusut, tetapi tanpa inovasi yang serius, kami tidak akan dapat memperkecil. Jadi jika kita tidak bisa membuat chip lebih besar dan transistor tidak bisa jauh lebih kecil, tidak bisakah kita membuat transistor yang ada berjalan lebih cepat? Ini adalah bidang lain yang telah memberikan manfaat di masa lalu, tetapi kemungkinan besar tidak akan berlanjut.

Sementara kecepatan prosesor meningkat setiap generasi selama bertahun-tahun, kecepatan prosesor tersebut telah terjebak di kisaran 3-5GHz selama dekade terakhir. Ini karena kombinasi dari beberapa hal. Jelas itu akan meningkatkan penggunaan daya, tetapi masalah utama lagi berkaitan dengan batasan transistor yang lebih kecil dan hukum fisika.

Saat kami membuat transistor lebih kecil, kami juga harus membuat kabel yang menghubungkannya lebih kecil, yang meningkatkan resistansinya. Kami secara tradisional dapat membuat transistor bekerja lebih cepat dengan mendekatkan komponen internalnya, tetapi beberapa sudah dipisahkan hanya oleh satu atau dua atom. Tidak ada cara mudah untuk melakukan yang lebih baik.

Dengan menggabungkan semua alasan ini, jelas bahwa kita tidak akan melihat jenis peningkatan kinerja generasi dari masa lalu, tetapi yakinlah ada banyak orang pintar yang menangani masalah ini.

Leave a Reply